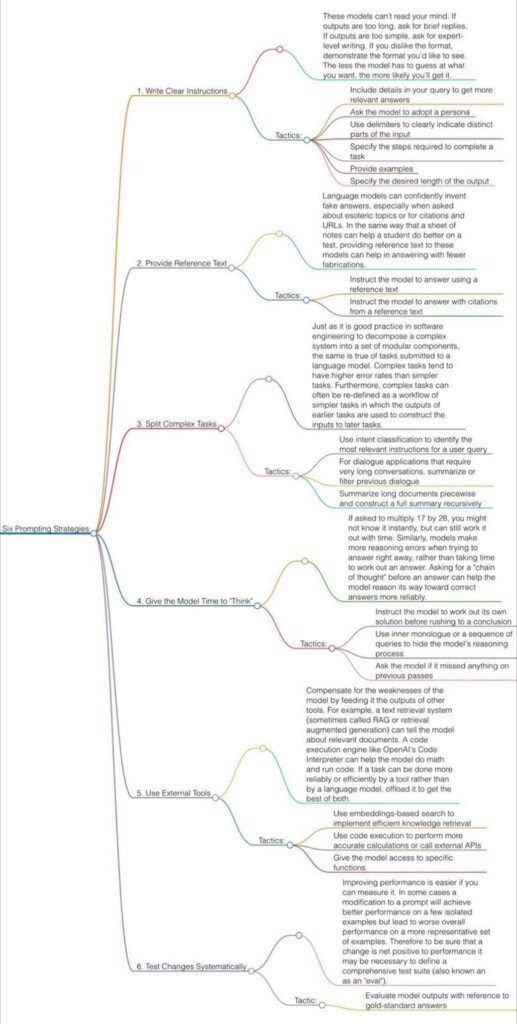

- klare Anweisungen

- die Verwendung von Referenztexten

- die Aufteilung komplexer Aufgaben

- Zeit zum Nachdenken

- die Verwendung externer Tools und

- die gezielte Auswertung von Aufforderungen

In diesem Leitfaden werden Strategien und Taktiken vorgestellt, mit denen du bessere Ergebnisse mit großen Sprachmodellen (manchmal auch als GPT-Modelle bekannt) wie dem GPT-4 erzielen kannst.

Die hier beschriebenen Methoden können manchmal auch in Kombination eingesetzt werden, um eine bessere Wirkung zu erzielen. Experimentiere herum, um die Methoden zu finden, die für dich am besten funktionieren.

Los gehts!

Sechs Strategien, um bessere Ergebnisse zu erzielen

1. Schreibe klare Anweisungen

Die Modelle können deine Gedanken nicht lesen. Wenn die Ergebnisse zu lang sind, bitte um kurze Antworten. Wenn die Ergebnisse zu simpel sind, bitte darum, sie auf Expertenniveau zu schreiben. Wenn du das Format nicht magst, zeige das Format, das du gerne hättest. Je weniger das Modell erraten muss, was du willst, desto wahrscheinlicher ist es, dass du es bekommst.

Taktiken

Taktik: Füge Details in deine Anfrage ein, um relevantere Antworten zu erhalten

Um eine relevante Antwort zu erhalten, musst du in deiner Anfrage alle wichtigen Details und den Kontext angeben. Sonst überlässt du es dem Modell, zu erraten, was du meinst.

Beispiele:

Nicht gut: Wie addiere ich Zahlen in Excel?

Besser: Ich möchte dies automatisch für ein ganzes Blatt von Zeilen tun, wobei alle Summen rechts in einer Spalte mit dem Namen „Gesamt“ stehen sollen.

Nicht gut: Wer ist der Staatspräsident?

Besser: Wer war 2021 der Präsident von Frankreich und wie oft wird gewählt?

Nicht gut: Schreibe einen Code, um die Fibonacci-Folge zu berechnen.

Besser: Schreibe eine TypeScript-Funktion, um die Fibonacci-Folge effizient zu berechnen. Kommentiere den Code großzügig, um zu erklären, was jeder Teil tut und warum er so geschrieben wurde.

Taktik: Das Modell auffordern, eine Persona zu übernehmen

Die Systemnachricht kann verwendet werden, um die Persona anzugeben, die das Modell in seinen Antworten verwendet.

Taktik: Verwende Begrenzungszeichen, um verschiedene Teile des Inputs klar zu kennzeichnen

Abgrenzungszeichen wie dreifache Anführungszeichen, XML-Tags, Abschnittsüberschriften usw. können helfen, Textabschnitte abzugrenzen, die unterschiedlich behandelt werden sollen.

Je komplexer eine Aufgabe ist, desto wichtiger ist es, die Details der Aufgabe eindeutig zu beschreiben. Lass das Modell nicht arbeiten, um genau zu verstehen, was du von ihm verlangst.

Taktik: Lege die Schritte fest, die zur Erfüllung einer Aufgabe erforderlich sind.

Manche Aufgaben lassen sich am besten als eine Abfolge von Schritten beschreiben. Wenn du die Schritte explizit aufschreibst, kann es für das Modell einfacher sein, ihnen zu folgen.

Beispiel:

Verwende die folgenden Schritt-für-Schritt-Anweisungen, um auf Benutzereingaben zu reagieren.

Schritt 1 – Der Nutzer gibt dir einen Text in dreifachen Anführungszeichen. Fasse diesen Text in einem Satz mit dem Präfix „Zusammenfassung:“ zusammen.

Schritt 2 – Übersetze die Zusammenfassung aus Schritt 1 ins Spanische, mit dem Präfix „Übersetzung: „.

Taktik: Bring Beispiele ein

Allgemeine Anweisungen zu geben, die für alle Beispiele gelten, ist in der Regel effizienter, als alle Varianten einer Aufgabe anhand eines Beispiels zu demonstrieren, aber in manchen Fällen kann es einfacher sein, Beispiele zu geben.

Zum Beispiel, wenn du willst, dass das Modell einen bestimmten Stil bei der Beantwortung von Nutzeranfragen kopiert, der sich nur schwer explizit beschreiben lässt. Dies wird als „few-shot“ Prompting bezeichnet.

Taktik: Gib die gewünschte Länge der Ausgabe an

Du kannst das Modell auffordern, Ergebnisse zu produzieren, die eine bestimmte Ziellänge haben. Die angestrebte Ausgabelänge kann in Form der Anzahl von Wörtern, Sätzen, Absätzen, Aufzählungspunkten usw. angegeben werden.

Beachte jedoch, dass die Anweisung an das Modell, eine bestimmte Anzahl von Wörtern zu erzeugen, nicht sehr genau funktioniert. Das Modell kann zuverlässiger Ausgaben mit einer bestimmten Anzahl von Absätzen oder Aufzählungspunkten erstellen.

Beispiel: Fasse den Text, der durch dreifache Anführungszeichen begrenzt ist, in etwa 50 Wörtern zusammen.

„““Text hier einfügen“““

Strategie: Referenztext bereitstellen

Taktik: Das Modell anweisen, anhand eines Referenztextes zu antworten

Wenn wir einem Modell zuverlässige Informationen zur Verfügung stellen können, die für die aktuelle Anfrage relevant sind, können wir das Modell anweisen, die bereitgestellten Informationen zu verwenden, um seine Antwort zu verfassen.

Beispiel: Verwende die angegebenen Artikel, die durch dreifache Anführungszeichen begrenzt sind, um Fragen zu beantworten. Wenn die Antwort nicht in den Artikeln zu finden ist, schreibe „Ich konnte keine Antwort finden“.

<Füge Artikel ein, die jeweils durch dreifache Anführungszeichen begrenzt sind>

Frage: <Frage hier einfügen>

Da alle Modelle begrenzte Kontextfenster haben, brauchen wir eine Möglichkeit, dynamisch nach Informationen zu suchen, die für die gestellte Frage relevant sind. Einbettungen können verwendet werden, um effizientes Wissen abzurufen. In der Taktik „Embedding-basierte Suche verwenden, um effizientes Wissen abzurufen“ erfährst du mehr darüber, wie man das macht.

Strategie: Komplexe Aufgaben in einfachere Teilaufgaben aufteilen

Taktik: Nutze die Absichtsklassifizierung, um die relevantesten Anweisungen für eine Benutzeranfrage zu identifizieren

Bei Aufgaben, für die viele unabhängige Anleitungen zur Bearbeitung verschiedener Fälle benötigt werden, kann es von Vorteil sein, zunächst die Art der Anfrage zu klassifizieren und anhand dieser Klassifizierung zu bestimmen, welche Anweisungen benötigt werden. Dies kann erreicht werden, indem man feste Kategorien definiert und Anweisungen fest kodiert, die für die Bearbeitung von Aufgaben in einer bestimmten Kategorie relevant sind.

Dieser Prozess kann auch rekursiv angewendet werden, um eine Aufgabe in eine Abfolge von Schritten zu zerlegen. Der Vorteil dieses Ansatzes ist, dass jede Abfrage nur die Anweisungen enthält, die für die Ausführung der nächsten Stufe einer Aufgabe erforderlich sind. Dies kann auch zu geringeren Kosten führen, da größere Abfragen mehr kosten (siehe Preisinformationen).

Nehmen wir zum Beispiel an, dass bei einer Kundendienstanwendung die Anfragen sinnvollerweise wie folgt klassifiziert werden könnten:

Du erhältst Anfragen an den Kundenservice. Klassifiziere jede Anfrage in eine primäre und eine sekundäre Kategorie. Stelle deine Ausgabe im json-Format mit den Schlüsseln: primär und sekundär bereit.

Primäre Kategorien: Abrechnung, Technischer Support, Kontoverwaltung oder Allgemeine Anfrage.

Sekundäre Rechnungskategorien:

– Abbestellen oder Upgrade

– Hinzufügen einer Zahlungsmethode

– Erklärung für eine Belastung

– Eine Gebühr anfechten

Technischer Support Sekundärkategorien:

– Fehlersuche

– Gerätekompatibilität

– Software-Updates

Kontoverwaltung Sekundärkategorien:

– Passwort zurücksetzen

– Persönliche Informationen aktualisieren

– Konto schließen

– Kontosicherheit

Allgemeine Anfrage Sekundärkategorien:

– Produktinformation

– Preisgestaltung

– Rückmeldung

– Sprich mit einem Menschen

Anhand der Klassifizierung der Kundenanfrage können dem Modell eine Reihe spezifischerer Anweisungen für die nächsten Schritte gegeben werden. Nehmen wir zum Beispiel an, dass der Kunde Hilfe bei der „Fehlersuche“ benötigt.

Du wirst mit Kundendienstanfragen konfrontiert, die eine Fehlerbehebung im Rahmen des technischen Supports erfordern. Hilf dem Benutzer, indem du:

– Bitte ihn, zu überprüfen, ob alle Kabel zum/vom Router angeschlossen sind. Es ist normal, dass sich Kabel mit der Zeit lösen.

– Wenn alle Kabel angeschlossen sind und das Problem weiterhin besteht, frag ihn, welches Routermodell er verwendet.

– Jetzt berätst du sie, wie sie ihr Gerät neu starten können:

— Wenn die Modellnummer MTD-327J lautet, rätst du ihnen, den roten Knopf zu drücken und 5 Sekunden lang gedrückt zu halten und dann 5 Minuten zu warten, bevor du die Verbindung testest.

— Wenn die Modellnummer MTD-327S lautet, rate ihnen, den Stecker zu ziehen und wieder einzustecken und dann 5 Minuten zu warten, bevor sie die Verbindung testen.

– Wenn das Problem des Kunden nach dem Neustart des Geräts und 5 Minuten Wartezeit weiterhin besteht, verbinde ihn mit dem IT-Support, indem du {„IT-Support angefordert“} ausgibst.

– Wenn der Nutzer beginnt, Fragen zu stellen, die nichts mit diesem Thema zu tun haben, bestätige, ob er den aktuellen Chat zur Fehlerbehebung beenden möchte und klassifiziere seine Anfrage nach dem folgenden Schema:

<Füge hier das primäre/sekundäre Klassifizierungsschema von oben ein>

Beachte, dass das Modell angewiesen wurde, spezielle Strings auszugeben, die anzeigen, wenn sich der Zustand der Konversation ändert. So können wir unser System in einen Zustandsautomaten verwandeln, bei dem der Zustand bestimmt, welche Anweisungen eingespeist werden. Indem wir den Zustand verfolgen, welche Anweisungen in diesem Zustand relevant sind und optional auch, welche Zustandsübergänge von diesem Zustand aus erlaubt sind, können wir die Benutzererfahrung mit Leitplanken versehen, die mit einem weniger strukturierten Ansatz schwer zu erreichen wären.

Taktik: Bei Dialoganwendungen, die sehr lange Unterhaltungen erfordern, fasse frühere Dialoge zusammen oder filtere sie.

Da Modelle eine feste Kontextlänge haben, kann ein Dialog zwischen einem Nutzer und einem Assistenten, bei dem das gesamte Gespräch im Kontextfenster enthalten ist, nicht unbegrenzt fortgesetzt werden.

Es gibt verschiedene Möglichkeiten, dieses Problem zu umgehen, z. B. durch die Zusammenfassung früherer Gesprächsabschnitte. Sobald die Eingabe eine bestimmte Länge erreicht, könnte eine Abfrage ausgelöst werden, die einen Teil der Konversation zusammenfasst, und die Zusammenfassung der vorherigen Konversation könnte als Teil der Systemnachricht eingefügt werden. Alternativ könnte die Zusammenfassung der vorherigen Konversation asynchron im Hintergrund während der gesamten Konversation erfolgen.

Eine andere Lösung besteht darin, dynamisch die Teile der Konversation auszuwählen, die für die aktuelle Anfrage am relevantesten sind. Siehe Taktik „Einbettungsbasierte Suche verwenden, um effizientes Knowledge Retrieval zu implementieren“.

Taktik: Lange Dokumente stückweise zusammenfassen und rekursiv eine vollständige Zusammenfassung konstruieren

Da Modelle eine feste Kontextlänge haben, können sie nicht verwendet werden, um einen Text zusammenzufassen, der länger ist als die Kontextlänge minus die Länge der generierten Zusammenfassung in einer einzigen Abfrage.

Um ein sehr langes Dokument wie z. B. ein Buch zusammenzufassen, können wir eine Reihe von Abfragen verwenden, um jeden Abschnitt des Dokuments zusammenzufassen. Die Zusammenfassungen der Abschnitte können miteinander verknüpft und zusammengefasst werden, wodurch Zusammenfassungen von Zusammenfassungen entstehen. Dieser Prozess kann rekursiv fortgesetzt werden, bis ein ganzes Dokument zusammengefasst ist. Wenn es notwendig ist, Informationen über frühere Abschnitte zu nutzen, um spätere Abschnitte zu verstehen, kann ein weiterer Trick nützlich sein, eine laufende Zusammenfassung des Textes vor einem bestimmten Punkt im Buch einzufügen, während der Inhalt an diesem Punkt zusammengefasst wird. Die Wirksamkeit dieses Verfahrens für die Zusammenfassung von Büchern wurde in früheren Untersuchungen von OpenAI mit Varianten von GPT-3 untersucht.

Strategie: Gib den Modellen Zeit zum „Nachdenken“

Taktik: Weise das Modell an, seine eigene Lösung zu erarbeiten, bevor es zu einer Schlussfolgerung kommt

Manchmal erhalten wir bessere Ergebnisse, wenn wir das Modell explizit anweisen, von den ersten Prinzipien auszugehen, bevor es zu einer Schlussfolgerung kommt. Nehmen wir zum Beispiel an, wir wollen, dass ein Modell die Lösung eines Schülers oder einer Schülerin für ein mathematisches Problem bewertet. Die naheliegendste Methode ist, das Modell einfach zu fragen, ob die Lösung des Schülers richtig ist oder nicht.

Stelle fest, ob die Lösung des Schülers richtig ist oder nicht.

Problemstellung: Ich baue eine Solarstromanlage und brauche Hilfe bei der Berechnung der Kosten.

– Das Grundstück kostet $100 / Quadratmeter

– Ich kann Solarmodule für 250 Dollar pro Quadratmeter kaufen.

– Ich habe einen Wartungsvertrag ausgehandelt, der mich pauschal $100 pro Jahr und zusätzlich $10 pro Quadratmeter kosten wird

Wie hoch sind die Gesamtkosten für das erste Betriebsjahr in Abhängigkeit von der Anzahl der Quadratmeter?

Antwort von ChatGPT:

Die Lösung des Schülers: Sei x die Größe der Anlage in Quadratmetern.

1. Grundstückskosten: 100x

2. Kosten für das Solarmodul: 250x

3. Wartungskosten: 100.000 + 100x

Gesamtkosten: 100x + 250x + 100.000 + 100x = 450x + 100.000

ChatGPT: Die Lösung des Schülers ist richtig.

Aber die Lösung des Schülers ist eigentlich nicht richtig!

Wir können das Modell dazu bringen, dies zu bemerken, indem wir es auffordern, zuerst seine eigene Lösung zu erstellen.

Beispiel:

Erarbeite zunächst deine eigene Lösung für das Problem. Vergleiche dann deine Lösung mit der des Schülers und bewerte, ob die Lösung des Schülers richtig ist oder nicht. Entscheide erst dann, ob die Lösung des Schülers richtig ist, wenn du die Aufgabe selbst gelöst hast.

Problemstellung: Ich baue eine Solarstromanlage und brauche Hilfe bei der Berechnung der Kosten. – Das Grundstück kostet $100 / Quadratfuß – Ich kann Solarmodule für $250 / Quadratfuß kaufen – Ich habe einen Wartungsvertrag ausgehandelt, der mich pauschal $100 pro Jahr und zusätzlich $10 / Quadratfuß kostet Wie hoch sind die Gesamtkosten für das erste Betriebsjahr in Abhängigkeit von der Anzahl der Quadratfuß. Die Lösung des Schülers: Sei x die Größe der Anlage in Quadratmetern. 1. Grundstückskosten: 100x 2. Kosten der Solarmodule: 250x 3. Wartungskosten: 100.000 + 100x Gesamtkosten: 100x + 250x + 100.000 + 100x = 450x + 100.000

x sei die Größe der Anlage in Quadratmetern. 1. Grundstückskosten: 100x 2. Kosten der Solarmodule: 250x 3. Wartungskosten: 100.000 + 10x Gesamtkosten: 100x + 250x + 100.000 + 10x = 360x + 100.000 Die Lösung des Schülers ist falsch. Er hat bei der Berechnung der Wartungskosten einen Fehler gemacht und 100x statt 10x verwendet. Die richtigen Gesamtkosten für das erste Betriebsjahr sind 360x + 100.000.

Taktik: Innerer Monolog oder eine Abfolge von Abfragen verwenden, um den Denkprozess des Modells zu verbergen

Die vorangegangene Taktik zeigt, dass es manchmal wichtig ist, dass das Modell ausführlich über ein Problem nachdenkt, bevor es eine bestimmte Frage beantwortet. Bei manchen Anwendungen wäre es unangebracht, den Denkprozess, den ein Modell verwendet, um zu einer endgültigen Antwort zu kommen, mit dem Nutzer zu teilen. In Nachhilfeprogrammen möchten wir die Schüler/innen zum Beispiel dazu ermutigen, ihre eigenen Antworten zu finden, aber der Denkprozess des Modells über die Lösung des Schülers/der Schülerin könnte die Antwort dem/der Schüler/in verraten.

Der innere Monolog ist eine Taktik, mit der man dies abmildern kann. Die Idee des inneren Monologs besteht darin, das Modell anzuweisen, Teile der Ausgabe, die vor dem Nutzer verborgen bleiben sollen, in ein strukturiertes Format zu bringen, das das Parsen erleichtert. Bevor die Ausgabe dem Nutzer präsentiert wird, wird sie geparst und nur ein Teil der Ausgabe wird sichtbar gemacht.

Befolge diese Schritte, um die Benutzeranfragen zu beantworten.

Schritt 1 – Erarbeite zunächst deine eigene Lösung für das Problem. Verlasse dich nicht auf die Lösung des Schülers/der Schülerin, denn sie könnte falsch sein. Schließe deine gesamte Arbeit für diesen Schritt in dreifache Anführungszeichen („““) ein.

Schritt 2 – Vergleiche deine Lösung mit der des Schülers und bewerte, ob die Lösung des Schülers richtig ist oder nicht. Schließe deine gesamte Arbeit für diesen Schritt in dreifache Anführungszeichen („““) ein.

Schritt 3 – Wenn der/die Schüler/in einen Fehler gemacht hat, überlege, welchen Hinweis du ihm/ihr geben kannst, ohne die Antwort zu verraten. Schließe deine gesamte Arbeit für diesen Schritt in dreifache Anführungszeichen („““) ein.

Schritt 4 – Wenn der/die Schüler/in einen Fehler gemacht hat, gibst du ihm/ihr den Hinweis aus dem vorherigen Schritt (außerhalb der Anführungszeichen). Anstatt „Schritt 4 – …“ schreibst du „Hinweis:“.

Problemstellung: <Problemstellung einfügen>

Schülerlösung: <Schülerlösung einfügen>

Alternativ kann dies auch mit einer Abfolge von Abfragen erreicht werden, bei denen die Ergebnisse aller Abfragen bis auf die letzte vor dem Endnutzer verborgen sind.

Zuerst können wir das Modell auffordern, das Problem selbst zu lösen. Da diese erste Abfrage die Lösung des Schülers/der Schülerin nicht erfordert, kann sie weggelassen werden. Das hat den zusätzlichen Vorteil, dass die Lösung des Modells nicht durch den Lösungsversuch der Schülerin oder des Schülers verfälscht werden kann.

<Problemstellung einfügen>

Als Nächstes können wir das Modell alle verfügbaren Informationen verwenden lassen, um die Richtigkeit der Lösung des Schülers/der Schülerin zu beurteilen.

Vergleiche deine Lösung mit der Lösung des Schülers/der Schülerin und bewerte, ob die Lösung des Schülers/der Schülerin richtig ist oder nicht.

Problemstellung: „““<Füge die Problemstellung ein>““

Deine Lösung: „““<Modell generierte Lösung einfügen>““

Die Lösung des Schülers: „““<Lösung des Schülers einfügen>““

Schließlich können wir das Modell seine eigene Analyse nutzen lassen, um eine Antwort in der Persona eines hilfreichen Tutors zu konstruieren.

Du bist ein Mathenachhilfelehrer. Wenn der Schüler/die Schülerin einen Fehler gemacht hat, gibst du ihm/ihr einen Hinweis, ohne die Antwort zu verraten. Wenn der Schüler keinen Fehler gemacht hat, gibst du ihm einfach einen aufmunternden Kommentar.

Problemstellung: „““<Füge die Problemstellung ein>““

Deine Lösung: „““<Modell generierte Lösung einfügen>““

Die Lösung des Schülers: „““<Lösung des Schülers einfügen>““

Analyse: „““<Füge die modellgenerierte Analyse aus dem vorherigen Schritt ein>“““

Taktik: Frage das Modell, ob es bei früheren Durchgängen etwas übersehen hat

Angenommen, wir verwenden ein Modell, um Auszüge aus einer Quelle aufzulisten, die für eine bestimmte Frage relevant sind. Nach der Auflistung jedes Auszugs muss das Modell entscheiden, ob es mit dem Schreiben eines weiteren Auszugs beginnen oder aufhören soll.Wenn das Quelldokument sehr umfangreich ist, kann es passieren, dass das Modell zu früh aufhört und nicht alle relevanten Auszüge auflistet. In diesem Fall kann die Leistung oft verbessert werden, indem das Modell mit Folgeabfragen aufgefordert wird, Auszüge zu finden, die es bei früheren Durchgängen übersehen hat.

Du erhältst ein Dokument, das durch dreifache Anführungszeichen begrenzt ist. Deine Aufgabe ist es, Auszüge auszuwählen, die sich auf die folgende Frage beziehen: „Welche bedeutenden Paradigmenwechsel gab es in der Geschichte der künstlichen Intelligenz?“.

Achte darauf, dass die Auszüge alle relevanten Kontexte enthalten, die du für ihre Interpretation brauchst – mit anderen Worten: Extrahiere keine kleinen Schnipsel, in denen wichtiger Kontext fehlt. Stelle die Ausgabe im JSON-Format wie folgt bereit:

[{„excerpt“: „…“},

…

{„excerpt“: „…“}]

USER

„““<Dokument hier einfügen>““

ASSISTENT

[{„excerpt“: „das Modell schreibt hier einen Auszug“},

…

{„excerpt“: „das Modell schreibt hier einen weiteren Auszug“}]

USER

Gibt es weitere relevante Auszüge? Achte darauf, dass du Auszüge nicht wiederholst. Achte auch darauf, dass die Auszüge den gesamten relevanten Kontext enthalten, der für ihre Interpretation notwendig ist – mit anderen Worten: Extrahiere keine kleinen Ausschnitte, denen wichtiger Kontext fehlt.

Strategie: Externe Tools verwenden

Taktik: Nutze die auf Einbettungen basierende Suche, um eine effiziente Wissensabfrage zu implementieren

Ein Modell kann auf externe Informationsquellen zurückgreifen, wenn diese Teil seiner Eingabe sind.Dies kann dem Modell helfen, fundiertere und aktuellere Antworten zu geben. Wenn ein Nutzer z. B. eine Frage zu einem bestimmten Film stellt, kann es sinnvoll sein, hochwertige Informationen über den Film (z. B. Schauspieler, Regisseur usw.) zur Eingabe des Modells hinzuzufügen. Mit Hilfe von Einbettungen lässt sich eine effiziente Wissensabfrage implementieren, sodass relevante Informationen zur Laufzeit dynamisch zur Modelleingabe hinzugefügt werden können.

Eine Texteinbettung ist ein Vektor, der die Verwandtschaft zwischen Textstrings messen kann. Ähnliche oder relevante Zeichenfolgen liegen näher beieinander als nicht verwandte Zeichenfolgen. Diese Tatsache und das Vorhandensein von schnellen Vektorsuchalgorithmen bedeuten, dass Einbettungen für eine effiziente Wissenssuche genutzt werden können. So kann ein Textkorpus in Teile (Chunks) aufgeteilt und jeder Chunk kann eingebettet und gespeichert werden. Dann kann eine bestimmte Abfrage eingebettet und eine Vektorsuche durchgeführt werden, um die eingebetteten Textabschnitte aus dem Korpus zu finden, die am meisten mit der Abfrage zu tun haben (d. h. im Einbettungsraum am nächsten beieinander liegen).

Beispielimplementierungen sind im OpenAI Cookbook zu finden.

In der Taktik „Das Modell anweisen, abgerufenes Wissen zur Beantwortung von Abfragen zu verwenden“ findest du ein Beispiel dafür, wie du Wissensabfragen nutzen kannst, um die Wahrscheinlichkeit zu minimieren, dass ein Modell falsche Fakten erfindet.

Taktik: Codeausführung nutzen, um genauere Berechnungen durchzuführen oder externe APIs aufzurufen

Bei Sprachmodellen kann man sich nicht darauf verlassen, dass sie selbst arithmetische oder lange Berechnungen genau durchführen. In Fällen, in denen dies erforderlich ist, kann ein Modell angewiesen werden, Code zu schreiben und auszuführen, anstatt eigene Berechnungen durchzuführen. Insbesondere kann ein Modell angewiesen werden, den Code, der ausgeführt werden soll, in ein bestimmtes Format wie z. B. Triple Backtick zu schreiben. Nachdem eine Ausgabe erstellt wurde, kann der Code extrahiert und ausgeführt werden. Schließlich kann die Ausgabe der Code-Ausführungsmaschine (z. B. des Python-Interpreters) bei Bedarf als Eingabe für das Modell für die nächste Abfrage verwendet werden.

Hier ist die offizielle Übersicht von OpenAI zum download

Du möchtest mehr über die Möglichkeiten Generativer KI im Marketing wissen und dein Team auf den neusten Stand bringen?

Sprechen wir darüber!

Schreibe eine E-Mail oder ruf einfach an: +49 151 664 64 64 2

Folge mir auf LinkedIn – so bleibst du bei den neusten Entwicklungen der Gen-KI auf dem Laufenden.

Dein Starterguide für Chat GPT

ChatGPT ist die aufregendste KI-Innovation seit Jahren. Die Möglichkeiten sind enorm – doch wie funktioniert diese Technologie und wie kann man sie optimal nutzen?

Mit dem ultimativen Guide auf 85 Seiten bist du auf dem neusten Stand der ChatGPT-Revolution.

Workshop KI im Marketing

KI und ChatGPT im Marketing und Vertrieb: Praxisorientierter Workshop für Unternehmer und Führungskräfte.

Die Kunst des

ChatGPT Promptings

In diesem Leitfaden lernst du von Experten, wie du überzeugende ChatGPT-Prompts formulierst, die zu spannenden und informativen Gesprächen führen.

Vom Verständnis der Prinzipien effektiver Prompts bis hin zur Beherrschung der Kunst, klare und prägnante Prompts zu formulieren, gibt dir dieses E-Book die Werkzeuge an die Hand, die du brauchst, um deine ChatGPT-Gespräche auf die nächste Stufe zu heben.

5 wertvolle ChatGPT Tipps - Kostenlos

5 wertvolle ChatGPT Tipps - Kostenlos

Verbessere deine Prompt-Fähigkeiten mit meiner ChatGPT-Anleitung. 🚀

– 5 Prompt-Tipps

– 16 Seiten

– 3-Minuten-Lektüre

Spannende Updates aus der GEN-KI Welt

KI-Wissen in dein Postfach

Regelmäßg | Kostenlos | Hilfreich | Jetzt KI-Wissen sichern